Conversión automática de vídeo a 3D Investigadores de la Universidad del Sur de California y Facebook desarrollan una espectacular técnica capaz de crear modelos 3D desde un vídeo

Los avances que estamos viendo últimamente en cuanto a aplicar inteligencia artificial al análisis de imágenes son espectaculares. Pero uno de los más recientes algoritmos nos ha llamado especialmente la atención. Se trata de un sistema desarrollado por la University of Southern California junto a Facebook Reality Labs y Facebook AI Research, que permite nada más y nada menos que la conversión automática de vídeo a 3D.

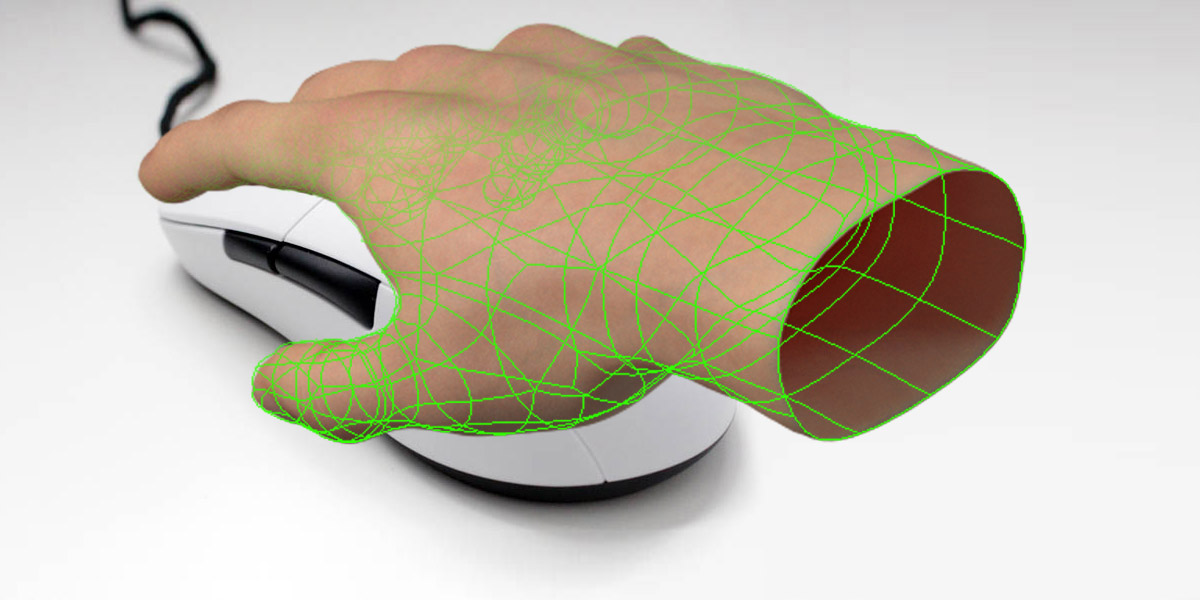

Este invento, que está especialmente pensado para la reconstrucción de modelos humanos en 3D, hace uso de potentes redes neuronales para «entender» cómo son los volúmenes que corresponderían a la persona que se ve en un vídeo.

Los investigadores afirman que, si bien tradicionalmente este enfoque se trataba de resolver analizando a baja resolución la imagen (por limitaciones de la memoria necesaria para llevar a cabo estos cálculos) y generando por tanto modelos de muy poca resolución, gracias a su desarrollo pueden crear una arquitectura multinivel que se puede entrenar (como ocurre con los sistemas basados en redes neuronales) en la que se analiza tanto la imagen completa a baja resolución como otros detalles a mayor calidad.

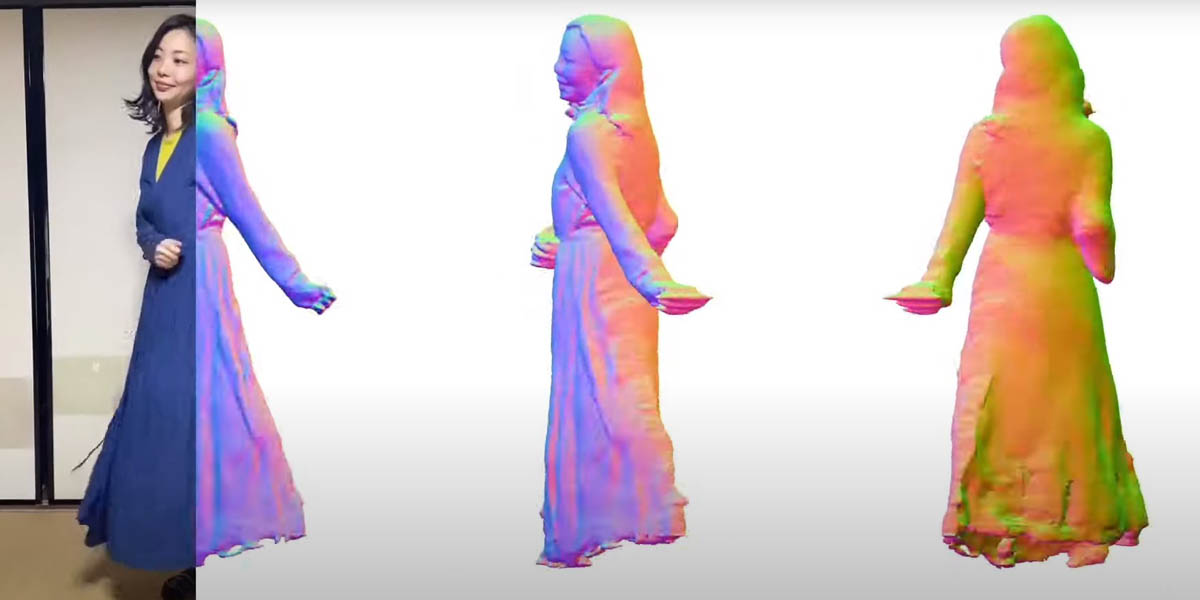

Conversión automática de vídeo a 3D: ¿cómo predecir la parte trasera del modelo?

Si reconstruir en 3D lo que vemos de una persona a partir de un vídeo de forma automática parece complicado, imagina pasar automáticamente de vídeo a 3D su espalda, que no aparece en la foto. Para hacer esto, los investigadores descubrieron que si, en vez de entrenar al modelo mediante los datos simplemente de color que se ven en el vídeo y el 3D frontal recreado, usaban las normales, el resultado era mucho mejor. Las normales son una forma de representar superficies 3D sin necesidad de contar con polígonos que den el volumen. Digamos que una normal le dice al programa cómo se refleja la luz en un punto de la superficie. Así, al contar con todo el mapa de normales (que es una simple imagen) de una superficie, el programa puede imaginarse su forma tridimensional. Esta información, al parecer, ha resultado mucho más útil a la hora de retroalimentar el sistema para que se imagine cómo debería ser la parte trasera de la persona que no se ve en la foto. Por supuesto, si hay algún elemento concreto en la parte trasera, el sistema no podrá «imaginárselo», pero sí que podrá dar una muy buena idea de cómo es la ropa por la zona de la espalda, si queda más o menos suelta, su forma, etc. Realmente impresionante.

Fuente: https://shunsukesaito.github.io/PIFuHD/

El paper de este estudio está publicado para que cualquiera que tenga curiosidad pueda profundizar más en el tema, así como el propio código que puedes descargarte y probar por ti mismo, disponible en GitHub. Su utilidad en la práctica aún no está clara, aunque estando Facebook por medio no me extrañaría que pronto viéramos alguna característica para ver vídeos en 3D en su plataforma (eso sí, saldrá un año antes para iOS… como ya ocurriera con la posibilidad de crear fotos en 3D, que por fin está disponible también para Android).

Un aplauso para estos investigadores, ¡por favor! 👏👏👏

Más info: Web del proyecto

Creador de Techandising. Ingeniero de Teleco y apasionado de la tecnología y el gaming 🕹️ desde que no sabía ni andar.

Me encanta probar a fondo todo tipo de cacharros y contarte mis impresiones aquí y en el canal de YouTube de Techandising 😊